El Monte Everest, pasarela de moda técnica: de la lana y el cuero al Gore-Tex

Con la llegada de la nieve, los amantes del esquí y los deportes de montaña pueden sonreír tranquilos. Les llega la hora de abrir los armarios y sacar esa vestimenta diseñada para soportar condiciones adversas y extremas de frío, nieve y viento.

Una hazaña que cumple 70 años

¡Ya les hubiera gustado a Sir. Edmund Hillary y Tenzing Norgay, en la primera expedición exitosa al Monte Everest en 1953, llevar esa chaqueta de Gore-Tex con la que desfilar pista abajo con los esquís! Pero no. En aquella época, los alpinistas utilizaban ropa de lana y cuero que era pesada y no siempre eficaz en condiciones extremas.

Desde entonces, los avances en tecnología han permitido el desarrollo de materiales más ligeros, transpirables y resistentes. El Monte Everest ha sido testigo de esta evolución, convertido en un escenario donde se han puesto a prueba la resistencia y eficacia de estos nuevos materiales técnicos.

Setenta años atrás, Hillary y Norgay contaron con los mejores materiales del momento, tecnologías y equipamiento que ahora parecen arcaicos, pero que en aquellos momentos eran de lo más revolucionario.

Llevaron ropa interior y camisa de lana, una camiseta interior de rejilla, un jersey de lana, pantalones y chaqueta de plumón y una capa de cortavientos. Hasta la aparición del nylon y el plástico, los tejidos de lana y pluma eran los que calentaban, y la lona lo que aislaba precariamente.

Los materiales vintage aquí no valen

El tramo final del ascenso al Everest presenta temperaturas medias de -35 ºC y vientos racheados que llegan fácilmente a los 160 km por hora. Sin embargo, desde aquel día hace ahora 70 años, han hecho cima más de 4 000 personas gracias a su pericia y a los avances científicos y técnicos que permiten una escalada más asequible.

¿Tanto pueden hacer los materiales por nosotros? En la última parte de la ascensión, los dos héroes del Everest llevaron consigo hasta 27 kilos. Ahora, el equipaje podría verse reducido a 10 kilos o menos gracias a los nuevos materiales, que se denominan ultraligeros.

Aunque ciertos materiales tradicionales como el cuero, la lana o el plumón siguen teniendo gran vigencia, se nos hace difícil concebir prendas técnicas que no incluyan estos materiales ultraligeros. En su libro High Adventure, Hillary describe cómo la lluvia y la nieve les complicaron el ascenso y les dificultaron el progreso.

“Las tormentas de nieve eran intensas y frecuentes. Las ráfagas de viento soplaban la nieve y la lluvia a través de nuestras ropas y nos empapaban completamente”.

En aquel momento, la impermeabilidad y transpirabilidad de sus prendas de ropa fueron casi un enemigo en vez de un aliado. Esos materiales podrían no alcanzar ni siquiera el primer nivel de impermeabilidad establecido bajo la norma europea ISO 811:1981.

A través de una técnica conocida como “columna de agua”, la medida en milímetros de la altura del agua contenida en un tubo en el momento en el que el agua empieza a traspasar el tejido indica su impermeabilidad. Hillary y Norgay llegaron al techo del mundo con una impermeabilidad de 0 a 5 000 mm, donde cero es no resistencia y 5 000 mm es una resistencia no muy alta: lluvia ligera, nieve seca, etc. Esto, unido a la baja transpirabilidad de sus prendas, hizo que acabaran empapados por su propio sudor, deshidratándose debido al enfriamiento súbito.

Gore-Tex

La investigación científica ha llevado a crear materiales sintéticos con características óptimas para su utilización en montaña. Es el caso de la poliamida (nailon) o el poliéster para el textil o las cuerdas, el neopreno por su capacidad aislante, la fibra de carbono por su ligereza y resistencia, el teflón por impermeabilidad y transpirabilidad, o la espuma EVA por su amortiguación.

El listado es interminable. Pero sin duda el material por excelencia es el Gore-Tex, un material sin límites. Se trata de una membrana de politetrafluoroetileno expandido que puede llegar a alcanzar columnas de agua hasta 28 000 mm. Este material permitió llegar al hombre a puntos y lugares que parecían inalcanzables. Fue elegido por la NASA para que los astronautas de la misión Apolo realizaran el viaje a la Luna. Y en 1989, los miembros de una expedición transantártica internacional no dudaron en llevar prendas exteriores Gore-Tex para atravesar el continente helado. Uno de los exploradores incluso afirmó que el laminado Gore-Tex le salvó la vida.

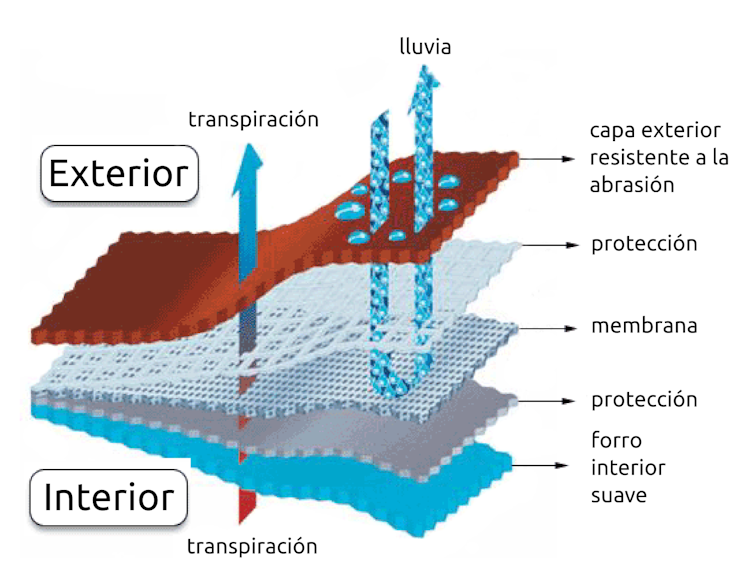

¿Cómo consigue ser impermeable a la vez que transpirable? El agua de lluvia está en estado líquido, mientras que el sudor está en estado gaseoso. El tamaño de una molécula de agua es miles de veces más grande que el de una molécula de sudor. Esto explica por qué, si el tamaño de los poros del Gore-Tex es suficientemente pequeño, el agua no va a poder pasar, mientras que el sudor lo tiene mucho más fácil. Y realmente es así: el tamaño de los poros es 20 000 veces más pequeño que el de las gotas de agua, sin embargo, es 700 veces mayor que las moléculas de sudor. Así se consigue que el tejido sea impermeable sin perder la capacidad de evacuar el sudor (transpirable).

Si comparamos una gota de agua con la tierra, el poro de la membrana sería un campo de fútbol, siendo el balón el tamaño de la molécula de sudor.

Nuevas generaciones de materiales

¿De donde va a venir la próxima generación de materiales aún más ligeros, resistentes, impermeables y transpirables?

Una posibilidad es que vengan de los materiales desarrollados para los high-altitude pseudo satélites (HAPS). Se trata de aeronaves sin tripulación que operan en la estratosfera, a unos 20 km de altura. Es decir, vehículos intermedios entre los satélites, que orbitan a altitudes mucho mayores, y los drones. Con ellos se podría crear una red de comunicaciones terrestres que cubra todas las áreas rurales, menos susceptible a interferencias y capaz de trabajar con nuevas tecnologías, como el 5G.

Para poder fabricar estas aeronaves, es necesario utilizar materiales que puedan resistir condiciones muy duras: humedad, temperaturas tan bajas como -60 ºC, alta concentración de ozono o radiación ultravioleta (UV) intensa. Además, es necesario que los materiales sean muy ligeros y resistentes, para no penalizar la capacidad ascensional del vehículo.

En el Instituto IMDEA Materiales, el grupo de High Performance Polymer Nanocomposites (HPPN) investiga materiales compuestos que combinan textiles resistentes con recubrimientos para protección UV. La combinación ya ha puesto algunos candidatos interesantes sobre la mesa, y se espera que la investigación conduzca al desarrollo de un HAPS prototipo de mayor tamaño, capaz de realizar un vuelo piloto.

Aunque por ahora han sido concebidos para fabricar pseudo satélites, en un futuro se podrán aplicar (si no directamente, al menos sí versiones de ellos) en la próxima generación de ropa para montañeros, para proporcionar aún más protección y comodidad a los exploradores del siglo XXI.![]()

María Dolores Martín, Ingeniería de materiales, IMDEA MATERIALES

Este artículo fue publicado originalmente en The Conversation. Lea el original.

Comparte esto:

- Entrada

- Haz clic para compartir en Threads (Se abre en una ventana nueva) Threads

- Haz clic para compartir en WhatsApp (Se abre en una ventana nueva) WhatsApp

- Haz clic para compartir en Reddit (Se abre en una ventana nueva) Reddit

- Haz clic para compartir en Telegram (Se abre en una ventana nueva) Telegram

- Haz clic para compartir en Mastodon (Se abre en una ventana nueva) Mastodon

- Haz clic para compartir en Bluesky (Se abre en una ventana nueva) Bluesky